ビッグデータとは?基礎から活用事例まで徹底解説

スマートフォンを使ってSNSに投稿すればテキストや画像データが生成され、ECサイトで商品を購入すれば購買履歴データが蓄積されます。さらにIoT機器からはセンサーによる温度や振動データがリアルタイムで送信され、動画配信サービスではユーザーの視聴履歴や操作履歴が常時記録されています。こうした膨大かつ多様なデータを処理し、価値に変える概念が「ビッグデータ」です。

近年、企業が競争優位を確立するためには「勘や経験」ではなく「データに基づく意思決定」が欠かせません。ビッグデータはその基盤を支える存在であり、活用の成否が企業の成長性を大きく左右します。本記事では、ビッグデータの基本的な定義や特徴から、具体的な活用分野、導入によるメリット、直面する課題、さらに導入を進めるステップまでを体系的に整理し、ビジネスと社会における可能性を探ります。

1. ビッグデータとは

ビッグデータとは「従来の技術やシステムでは処理が困難な規模や複雑さを持つデータ群」を指します。重要なのは、単に量が膨大であるだけではなく、テキストや数値、画像、音声、動画、センサー情報といった異なるフォーマットを含み、さらに生成・流通の速度が極めて速い点です。従来のデータベース管理システムでは処理が追いつかず、新たな基盤や手法が必要となります。

また、ビッグデータの価値は「収集」そのものにあるのではなく、「分析して有用な知見を得ること」にあります。たとえば小売業では購買履歴を分析して顧客ごとに異なるキャンペーンを提供し、金融業界では取引パターンを解析して不正検知に役立てています。ビッグデータは、情報社会における「新しい石油」とも呼ばれるほど、事業の成長に不可欠な資源なのです。

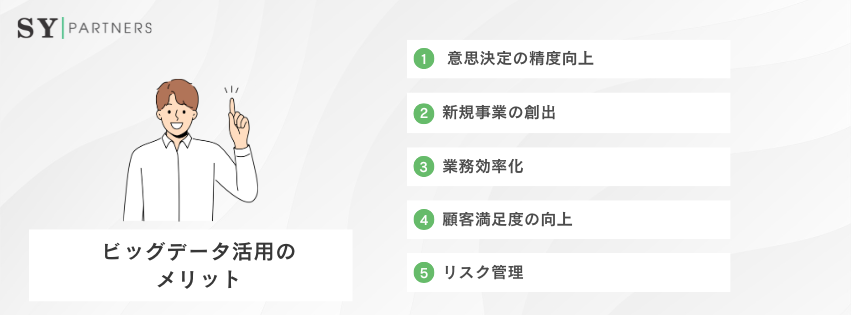

1.1 ビッグデータ活用のメリット

ビッグデータは導入・活用によって以下のような具体的なメリットをもたらします。

メリット | 詳細 | 実例 |

| 意思決定の精度向上 | 勘や経験ではなく、データに基づいた客観的判断が可能に | 小売業での在庫最適化 |

| 新規事業の創出 | 膨大なデータから潜在需要を発見し、新サービスを展開 | モビリティサービスの需要予測 |

| 業務効率化 | データ解析によりプロセスを最適化し、コスト削減 | 物流の配送ルート最適化 |

| 顧客満足度の向上 | 個別化サービスでユーザー体験を改善 | ECサイトでのレコメンド機能 |

| リスク管理 | 不正や故障を予測し、被害を未然に防止 | 金融の不正取引検出、工場異常検知 |

これらは単なる「効率化」にとどまらず、新たな収益モデルやビジネスの競争優位を構築する基盤となります。

1.2 従来データとの違い

ビッグデータは、従来の業務データとは性質も扱い方も大きく異なります。以下の表に、両者の違いを整理しました。

項目 | 従来データ | ビッグデータ |

| データの種類 | 主に構造化データ(売上、会計、顧客基本情報など) | 非構造化データを含む(SNS投稿、動画、音声、IoTセンサー値など) |

| 規模 | ギガバイト〜テラバイト単位が中心 | ペタバイト〜エクサバイト級まで拡大 |

| 収集頻度 | 日次や月次でのバッチ処理が中心 | リアルタイムで絶えず生成・収集 |

| 分析目的 | 過去の実績把握や会計処理が中心 | 未来予測や行動分析、需要予測など意思決定支援 |

| 処理技術 | Excelや従来型RDBMSで十分に対応可能 | HadoopやSpark、クラウドデータレイクなど分散処理基盤が必要 |

| 活用範囲 | 経営管理や社内レポーティングが中心 | マーケティング最適化、製造現場の予知保全、AI学習データなど幅広い領域 |

ビッグデータは「量」「種類」「速度」すべてにおいて従来データとは次元が異なります。さらに、利用目的も「過去の記録管理」から「未来を見据えた意思決定」へと進化している点が大きな特徴です。

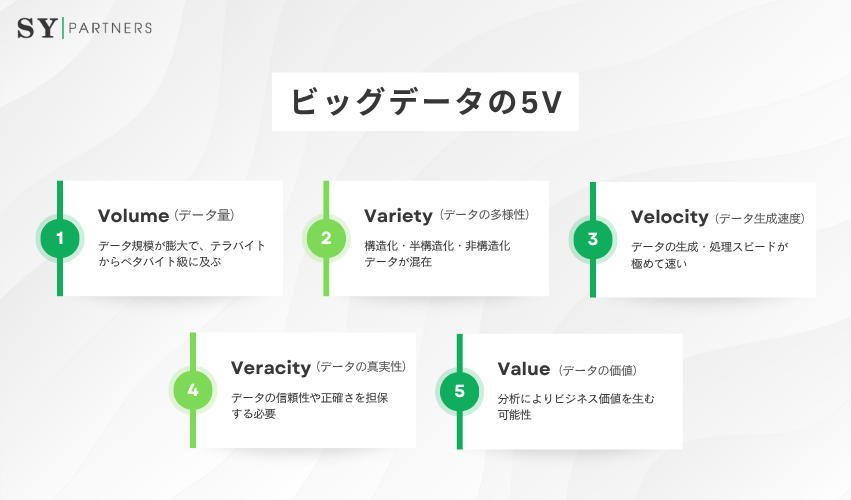

2. ビッグデータを構成する5つの要素

ビッグデータを特徴づける代表的な枠組みは「3Vモデル」です。Volume(量)、Variety(多様性)、Velocity(速度)の3つを基盤とし、さらにVeracity(正確性)とValue(価値)を加えた「5Vモデル」が広く利用されています。

特徴 | 説明 | 実例 |

| Volume(量) | データ規模が膨大で、テラバイトからペタバイト級に及ぶ | 毎日のSNS投稿やECサイトの購買履歴 |

| Variety(多様性) | 構造化・半構造化・非構造化データが混在 | テキスト、ログ、音声、画像、動画 |

| Velocity(速度) | データの生成・処理スピードが極めて速い | リアルタイム株式取引やIoTセンサー情報 |

| Veracity(正確性) | データの信頼性や正確さを担保する必要 | フェイク情報や異常値の排除 |

| Value(価値) | 分析によりビジネス価値を生む可能性 | 需要予測、UX改善、新規事業開発 |

ビッグデータの本質は「ただの大量情報」ではなく、「複雑かつ高速なデータを信頼できる形に整え、ビジネス価値に転換する」ことにあります。

3. ビッグデータを支える主要技術

ビッグデータの価値を引き出すためには、膨大で多様なデータを効率的に処理し、分析可能な形に変換する技術基盤が不可欠です。ここでは、代表的な技術とその役割を整理します。

技術領域 | 代表例 | 主な役割 | メリット |

| 分散処理基盤 | Hadoop, Spark | 大規模データの分散処理 | 高速処理、耐障害性 |

| クラウド基盤 | AWS, Azure, GCP | 柔軟なデータ基盤、スケーラビリティ | 初期投資削減、迅速導入 |

| データベース | NoSQL, データレイク | 構造化/非構造化データの格納 | 多様なデータに対応 |

| 可視化ツール | Tableau, Power BI | データの理解と意思決定支援 | 視覚的で直感的 |

| AI/機械学習 | TensorFlow, PyTorch | データから予測や分類を実行 | 高精度なモデル構築 |

3.1 分散処理基盤(Hadoop・Sparkなど)

ビッグデータの処理では、1台のサーバーで全てを処理するのは非現実的です。そのため、複数のコンピュータに処理を分散させる「分散処理技術」が用いられます。Hadoopはストレージと分散処理の標準的基盤として広く利用され、Sparkはインメモリ処理によって高速な分析を可能にしています。

これらは大規模データの前処理やバッチ分析に欠かせません。

3.2 クラウドプラットフォーム(AWS, Azure, GCP)

近年はオンプレミスで大規模基盤を構築するのではなく、クラウドを活用するのが主流です。Amazon Web Services(AWS)、Microsoft Azure、Google Cloud Platform(GCP)などは、スケーラブルで柔軟なデータ基盤を提供しており、初期投資を抑えつつ迅速に導入できます。

また、データレイクやサーバーレス分析環境を備えているため、利用規模に応じた拡張が可能です。

3.3 データベース技術(NoSQL, データレイク)

従来のRDBMS(リレーショナルデータベース)は構造化データの管理には適していますが、ビッグデータのような非構造化データには不向きです。そこで登場するのが、ドキュメント指向やカラム指向のNoSQLデータベースです。MongoDBやCassandraなどは柔軟なスキーマを持ち、ログやセンサー情報の格納に適しています。

また、データレイクは構造化・非構造化を問わずあらゆるデータを保存し、後から自由に分析できる特徴があります。

3.4 データ可視化・BIツール

ビッグデータの真価は「洞察を得ること」にあります。そのためには、複雑なデータを人間が理解しやすい形に変換する可視化ツールが必要です。TableauやPower BIなどのBIツールは、ドラッグ&ドロップでグラフやダッシュボードを作成でき、経営層や現場担当者が直感的にデータを理解できます。

これにより、データに基づく意思決定が加速します。

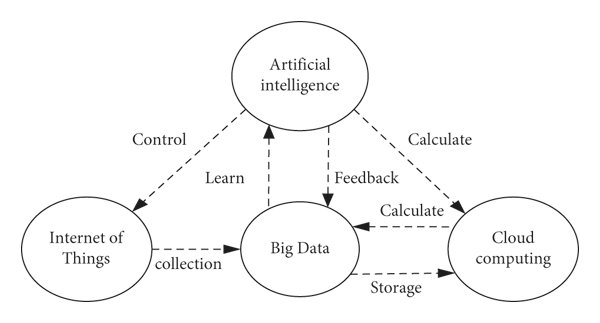

3.5 機械学習・AIとの統合

ビッグデータとAIは密接に結びついています。膨大なデータを学習させることで、機械学習モデルは高精度な予測や分類を実現します。特にディープラーニングは、画像認識や自然言語処理の分野で大きな成果をあげており、ビッグデータの存在がなければ成立しません。逆にAIがデータから価値を引き出すことで、ビッグデータ活用の幅は飛躍的に広がっています。

ビッグデータの活用には単一の技術ではなく、複数の技術を組み合わせてエコシステムを構築することが求められます。

基盤となる分散処理やクラウドの上に、データベースや可視化ツール、さらにAIを組み合わせることで、初めてデータから価値を引き出せるのです。

4. ビッグデータ導入の課題

メリットが大きい一方で、ビッグデータ導入には克服すべき課題も存在します。

課題 | 詳細 | 実例 |

| 高コスト | データ基盤の構築やクラウドサービス利用には高額な投資が必要 | 中小企業では投資判断が難しい |

| データ品質 | ノイズや欠損が多いと正確な分析が困難 | IoTセンサー異常によるデータ汚染 |

| 人材不足 | データサイエンティストやエンジニアが不足 | 採用競争が激化、コスト増大 |

| セキュリティ | 個人情報や機密データの漏洩リスク | GDPR違反による罰則事例も |

| 組織文化 | データ活用文化を根付かせるのに時間がかかる | “勘と経験”文化からの転換が必要 |

技術的な壁を超えるだけでなく、人材育成や文化変革を並行して進めることが成功の条件です。

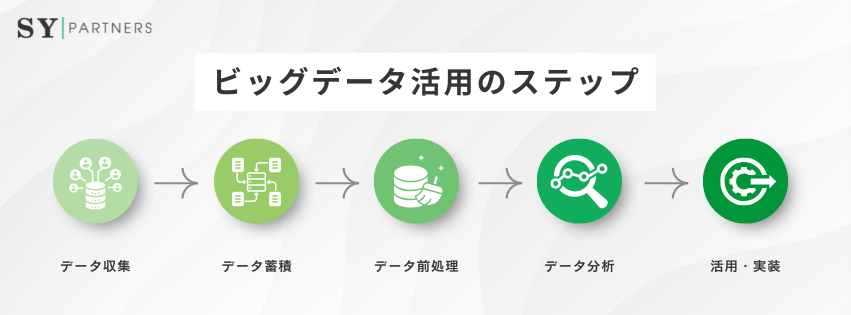

5. ビッグデータ活用のステップ

ビッグデータ活用を成功させるには、段階的なアプローチが不可欠です。

5.1 データ収集

ビッグデータ活用の出発点はデータ収集です。IoT機器、業務システム、SNS、外部オープンデータなど、あらゆる情報源から効率的に収集する体制が必要です。データ収集段階での漏れや偏りは、分析の精度に直接影響します。

5.2 データ蓄積

収集したデータを保存するためには、クラウド型データレイクや分散型データベースを利用します。従来のデータベースでは非構造化データに対応できないため、柔軟性とスケーラビリティを持つ仕組みが不可欠です。

5.3 データ前処理

データは生のままでは使えません。ノイズ除去、欠損補完、重複排除、正規化といった前処理が必要です。このプロセスが不十分だと、いくら高度なアルゴリズムを使っても正しい結果を得ることはできません。

5.4 データ分析

BIツールや機械学習を用いてパターンや相関を発見します。需要予測や顧客セグメント化など、分析の方向性を明確にすることが重要です。リアルタイム分析を導入することで、よりスピーディな意思決定も可能になります。

5.5 活用・実装

最終ステップは分析結果を実務に反映させることです。マーケティング戦略や在庫最適化、予知保全、新規事業の創出など、現場で具体的に役立つ形に落とし込む必要があります。小規模なPoCから始めて成果を検証し、徐々に全社的にスケールさせるのが成功の鍵です。

6. ビッグデータの活用分野

ビッグデータは幅広い業界で活用されており、その応用範囲は年々拡大しています。

6.1 マーケティング

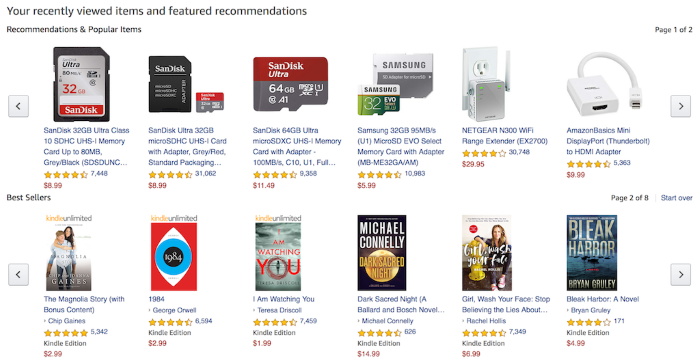

顧客の購買履歴やアクセスログ、SNSの書き込みを統合分析することで、顧客ごとの嗜好や購買行動を予測できます。Amazonのレコメンド機能やNetflixの視聴提案はその典型例であり、ユーザーごとに異なる体験を提供することで顧客満足度とLTVを向上させています。

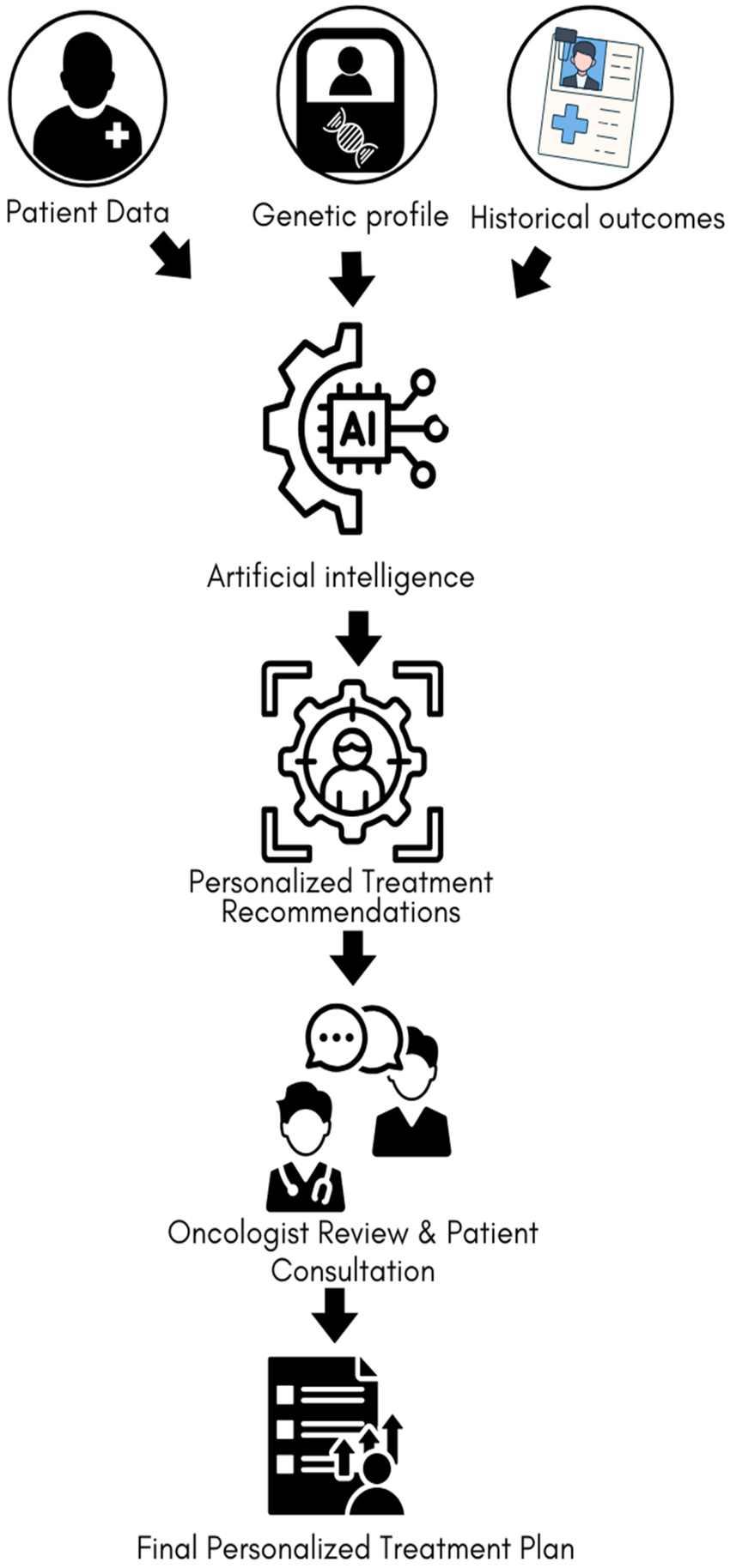

6.2 医療

電子カルテや画像診断データ、ウェアラブルデバイスの情報を解析することで、疾患の早期発見や治療効果の予測に役立ちます。たとえば、がん患者の治療計画にAIを組み込むことで、従来の標準治療に比べて高い成果をあげるケースが増えています。個別化医療の実現はビッグデータ活用なしには語れません。

6.3 製造業

工場のIoTセンサーから収集される稼働データを用いると、異常検知や故障予測(予知保全)が可能になります。従来の定期点検ではなく、データドリブンな保守を行うことでコストを削減しつつ稼働率を高められます。これが「スマートファクトリー」の中心概念です。

6.4 金融

金融業界では、取引データや顧客行動を解析して不正検知や信用リスク管理を行っています。AIによるリアルタイム分析は、従来見逃されがちだった微細なパターンを検知し、セキュリティ強化と顧客体験向上の両立を可能にしています。

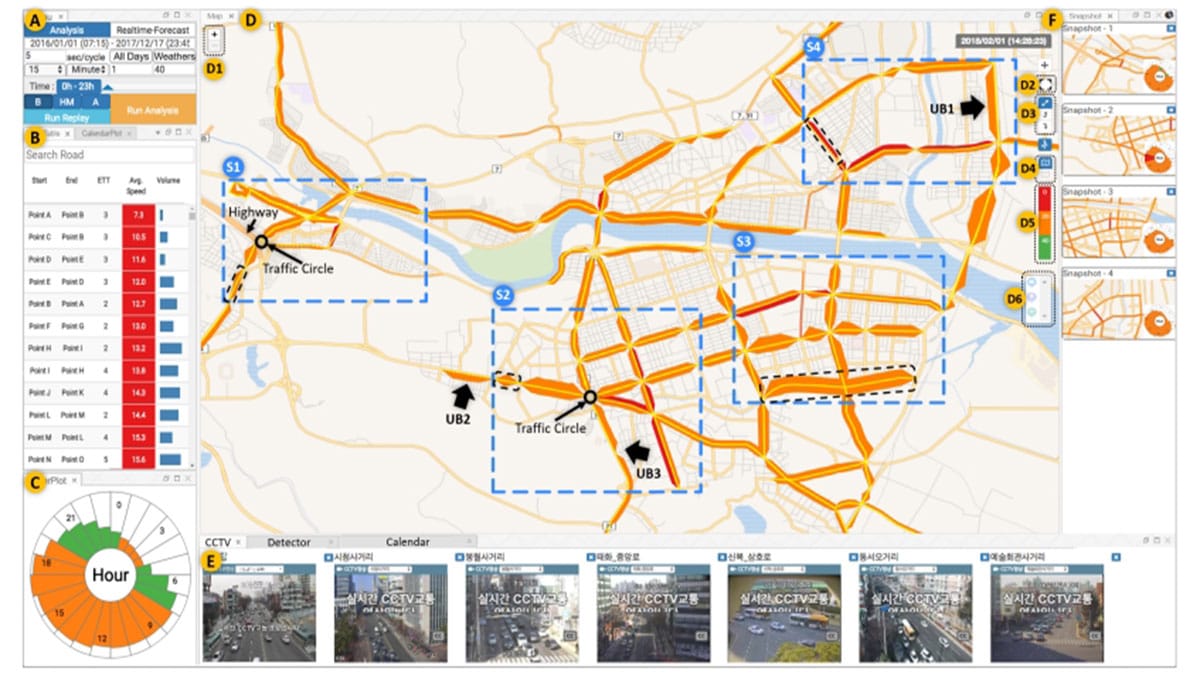

6.5 公共・交通

都市インフラにおけるビッグデータ活用は、交通渋滞の予測や公共交通の運行最適化に直結します。GPSデータや交通センサーを統合し、AIが渋滞を予測すれば、都市全体の効率が向上します。災害発生時にはSNSデータを活用して被害状況を即時に把握し、救援活動に役立てる事例もあります。

7. ビッグデータとAIの関係

ビッグデータとAI(人工知能)は、切り離せない関係にあります。AIは大量のデータを必要とし、ビッグデータはAIによって初めて効率的かつ高度に価値を生み出すことができます。

両者は相互補完的に進化しており、現代のデータ駆動型社会を支える二大要素といえます。

領域 | ビッグデータの役割 | AIの役割 |

| マーケティング | 膨大な顧客行動データを提供 | データから個別化提案を生成 |

| 製造業 | センサーや稼働データを収集 | 故障予測や生産最適化を実施 |

| 医療 | 電子カルテや画像診断データを蓄積 | 疾患予測や診断支援を行う |

| 金融 | 膨大な取引データを供給 | 不正検知や信用スコアリング |

| 物流 | 配送履歴や需要データを提供 | ルート最適化や需要予測を実現 |

7.1 AIがビッグデータを必要とする理由

AI、とりわけ機械学習やディープラーニングのモデルは、大量の学習データを基盤として成り立っています。画像認識AIが数百万枚の画像データを使って学習するように、精度の高い予測や分類を行うには多様で膨大なデータが不可欠です。

もしデータが偏っていたり少なすぎたりすると、AIは誤った結論を導き出すリスクが高まります。したがって、ビッグデータはAIを成長させる「燃料」として機能しています。

7.2 AIがビッグデータを価値化する仕組み

逆に、膨大なデータはAIなしには活用が難しいのも事実です。人間がペタバイト級のログやテキストを直接分析するのは不可能であり、AIのアルゴリズムがデータのパターンを抽出し、異常を検知し、将来の予測を可能にします。

たとえば金融業界では、AIが取引データから不正をリアルタイムに発見し、医療業界では患者データを解析して疾患リスクを早期に提示するなど、ビッグデータはAIを通じて価値へと変換されます。

7.3 ビッグデータ×AIの応用分野

両者が結びつくことで、以下のような実務的な応用が可能になります。

- マーケティング:購買データや行動ログをAIが分析し、顧客ごとに最適な広告や商品を提示する。

- 製造業:IoTセンサーからのデータをAIが解析し、異常を検知して故障を未然に防ぐ。

- 医療:画像診断やゲノムデータをAIが解析し、従来より高精度な診断支援を実現する。

- 金融:リアルタイム取引データをAIが分析し、不正やリスクを即座に発見する。

- 物流:配送データをAIが最適化し、コスト削減と迅速な配送を両立する。

8. ビッグデータ導入の成功事例

ビッグデータは理論だけでなく、実際の企業活動や社会課題解決においても成果を上げています。以下では、小売、エンターテインメント、製造業、医療、金融の5つの分野を中心に具体的な事例を見ていきます。

業界 | 企業・事例 | 活用内容 | 成果 |

| 小売 | Amazon | 購買履歴・検索履歴分析によるパーソナライズ | 売上増加、在庫最適化 |

| エンタメ | Netflix | 視聴データ分析によるコンテンツ推薦 | 解約率低下、オリジナル作品の成功率向上 |

| 製造 | GE | IoTデータを用いた予知保全 | ダウンタイム削減、コスト削減 |

| 医療 | 米国大規模病院 | 電子カルテ・ゲノム解析 | 疾患リスク予測、救命率向上 |

| 金融 | American Express | 取引データのリアルタイム分析 | 不正検知精度向上、解約率低下 |

8.1 小売業(Amazon)

Amazonはビッグデータ活用の代表格です。同社は顧客の購買履歴や閲覧履歴、検索キーワード、さらにはカートに入れて購入しなかった商品までを分析対象とし、個々のユーザーに合わせたレコメンドを生成しています。これにより顧客体験を向上させるだけでなく、クロスセル・アップセルを促進し、売上全体の大部分をパーソナライズによる購買から得ています。さらに物流面でも、需要予測を基にした在庫配置や配送ルート最適化を行い、コスト削減と顧客満足度の両立を実現しています。

8.2 エンターテインメント(Netflix)

Netflixは視聴履歴や評価データ、再生停止のタイミングなど膨大なユーザー行動データを分析し、パーソナライズされたコンテンツ提案を実現しています。これによりユーザーが「観たい作品にすぐ出会える」環境を提供し、解約率を大幅に低減しています。さらに、オリジナル作品制作にもデータを活用しており、どのジャンルや俳優がユーザーに支持されるかを事前に把握することで、ヒット作品の確率を高めています。

8.3 製造業(GE・インダストリアルIoT)

GE(General Electric)は、工場設備や航空機エンジンに設置されたセンサーからリアルタイムでデータを収集し、予知保全に活用しています。数百万点に及ぶ稼働データをAIで解析することで、故障が発生する前に異常兆候を検出し、メンテナンスを効率化しています。その結果、稼働率が向上し、顧客へのダウンタイムを最小化することに成功しました。これは「インダストリー4.0」における典型的な成功事例です。

8.4 医療(米国医療機関のデータ活用)

米国の大規模病院では、電子カルテやゲノムデータ、ウェアラブルデバイスから収集される情報を統合し、患者ごとのリスク予測を行っています。例えば、心疾患患者の心拍データをリアルタイムで監視し、異常が見られた場合には即座に医師に通知する仕組みを導入しました。これにより緊急搬送や死亡リスクを大幅に減少させる成果をあげています。また、がん研究においても膨大なゲノムデータを解析し、個別化医療(Precision Medicine)の実現に役立っています。

8.5 金融(American Express)

American Expressは顧客の取引履歴を分析し、不正利用の早期検知に成功しています。従来のルールベースの検出方法では見逃されがちなパターンも、機械学習を活用することでリアルタイムに検出できるようになりました。さらに、解約の兆候を持つ顧客をデータから特定し、事前に対策を講じることで解約率を大幅に下げることにも成功しています。

ビッグデータは業種を問わず多様な領域で成果を上げています。共通するのは、単に「データを蓄積する」のではなく、「目的を明確にし、分析結果を具体的なアクションにつなげる」という姿勢です。

おわりに

ビッグデータは単に「大量のデータを扱う技術」ではなく、そこから「価値を創造するための基盤」です。マーケティングから医療、製造、金融、公共まで幅広い分野で導入が進み、社会や経済の仕組みを変えつつあります。一方で、コストや人材不足、データ品質、セキュリティといった課題も避けては通れません。

企業がビッグデータを活用するには、段階的に基盤を整えつつ、組織文化を「データ駆動型」に変革する必要があります。小さな成功事例を積み上げることで、ビッグデータは単なる情報から「事業を成長させる資産」へと進化します。未来の競争力は、データをいかに価値に変換できるかにかかっているのです。

EN

EN JP

JP KR

KR