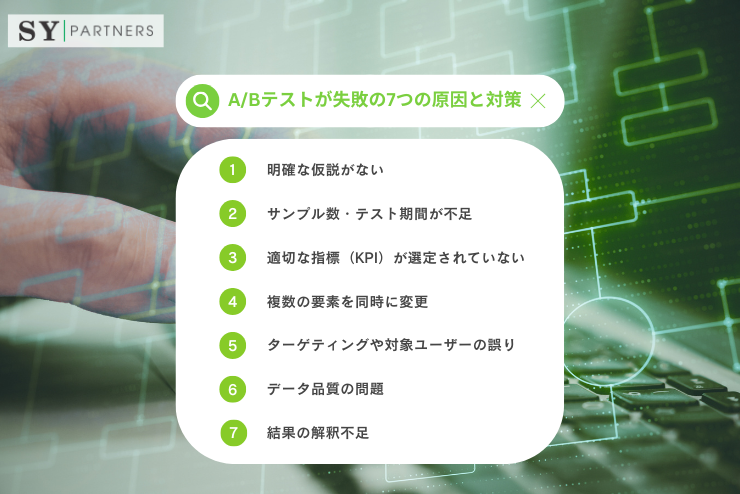

A/Bテストが失敗する7つの原因と対策

A/Bテストは「どちらが勝ったか」を決めるための施策ではなく、ユーザー理解を深め、改善を積み上げるための検証プロセスです。しかし実務では、テスト自体は回しているものの、成果につながらない・学びが残らないケースが少なくありません。その多くはツールや手法の問題ではなく、設計・運用・解釈のどこかにズレがあることが原因です。

本記事では、A/Bテストでよく起きる代表的な失敗パターンを7つに分け、それぞれについて「なぜ起きるのか」「どう防ぐのか」を整理しています。仮説設計、サンプル数、KPI設定、変更範囲、ターゲティング、データ品質、結果解釈まで、テストを「当てる作業」から「学びを生む仕組み」へ変えるための視点をまとめました。A/Bテストを継続的な改善力に変えたいチームにとって、設計のチェックリストとしても使える内容になっています。

1. 明確な仮説がない

A/Bテストで最も多い失敗は、施策そのものではなく「なぜそれを試すのか」が曖昧なまま走ってしまうことです。仮説が弱いと、結果が出ても再現性のある学びにならず、次の改善に繋がりません。まずは「テスト設計の芯」として仮説を置けているかが重要です。

1.1 失敗の原因

仮説が曖昧だと、テスト結果が良い/悪いという判断以外に学びが得られません。単に変更してみただけのテストでは、「なぜ上がったのか」「なぜ下がったのか」を説明できず、成功パターンの再現も難しくなります。さらに、関係者の合意も弱くなり、結果が出なかったときに「次に何をするか」が迷走しやすくなります。

また、仮説がないまま複数案を回すと、検証の焦点が散り、改善の蓄積が起きにくくなります。A/Bテストは“当てるゲーム”ではなく“学びを積む仕組み”なので、仮説がない状態はその前提を崩してしまいます。

1.2 解決策

テスト前に「何をどう改善したいか」を明確にした仮説を立てます。具体的には、問題点・変更内容・期待される効果・評価指標をセットで定義し、関係者が同じ理解で実行できる状態にします。たとえば「入力項目が多く離脱が増えている→住所入力を簡略化→フォーム完了率が上がる→KPIはチェックアウト完了率」のように、因果の筋道を言語化します。

加えて、仮説は1行で言えるレベルまで絞るのが有効です。短い仮説ほど検証が明確になり、結果解釈もぶれにくくなります。テストを始める前に「どの結果が出たら次に何をするか」まで決めておくと、学びが運用に定着します。

2. サンプル数・テスト期間が不足

A/Bテストは統計の上に成立するため、母数が足りないと結論が「たまたま」に支配されます。短期間で判断したくなるほど、誤判定のリスクは上がります。特にCVのような発生頻度が低い指標ほど、必要なサンプルは増えます。

2.1 失敗の原因

十分なサンプル数やテスト期間がないと、統計的に意味のある結果を得にくく、結果がノイズに埋もれてしまいます。差が出たように見えても偶然の可能性が高く、逆に本当に効いている施策を「効果なし」と判断してしまうことも起こります。

また、曜日要因や給料日、キャンペーンなど、外部要因の影響が入りやすいのも落とし穴です。短い期間だと偏りを平均化できず、テストの信頼性が下がります。

2.2 解決策

トラフィック量を基に必要なサンプル数を見積もり、十分な期間テストを実施します。CV数の目安として1,000件以上を確保するなど、あらかじめ計画を立てることで誤判定を防ぎます。実務では、最低でも複数の曜日を跨ぐ期間を取り、周期性の影響を受けにくくするのが基本です。

加えて、テスト停止の条件を先に決めておくと運用が安定します。「途中で上がって見えたから止める」などの判断はバイアスを生みやすいので、必要サンプル到達までは原則走らせる、というルールを持つことが重要です。

3. 適切な指標(KPI)が選定されていない

KPIがズレていると、テストが成功しても「事業成果に効かない」状態になります。逆に、事業成果に直結する指標だけを見てしまい、原因の手がかりを失うこともあります。KPI設計は、A/Bテストの成否を分ける設計要素です。

3.1 失敗の原因

複数の指標を同時に比較したり、目的と関連の薄い指標を設定すると、どの変更が成果に影響したのか分からなくなります。例えばクリック率だけを見て判断すると、購入や継続利用に悪影響が出ているのに気づけないことがあります。

また、指標が多いほど「どれかが良く見える」状態が起きやすく、都合の良い解釈を選んでしまうリスクも高まります。結果として、改善が積み上がらず、チームの意思決定が不安定になります。

3.2 解決策

テストの目的に直結する主要な評価指標を1〜2つに絞り、それを成功基準として設定します。二次的な指標は「補助的な分析」として位置づけ、主要KPIの結果を説明するために使います。例えば主要KPIをCVRに置き、補助としてフォーム完了率・エラー率・平均購入単価などを見る、といった整理が有効です。

さらに、ガードレール指標(悪化したら止める指標)を設定すると安全です。短期CVRは上がっても返品率や解約率が悪化するケースがあるため、最低限守るべき品質指標を持つと、施策の「危険な成功」を防げます。

4. 複数の要素を同時に変更

一度に多くを変えると、結果が出ても「何が効いたのか」が分からなくなります。A/Bテストは検証のための仕組みなので、原因が特定できないテストは改善を前に進めません。

4.1 失敗の原因

ボタン色・文言・配置など複数要素を一度に変更してしまうと、結果からどの要素が影響したのか特定できません。良い結果が出ても再現性がなく、次の改善に繋がらないのが最大の問題です。逆に悪い結果が出た場合も、何を戻せば良いのか分からず、改善サイクルが止まりやすくなります。

さらに、複数要素を同時に変えると「意図しない相互作用」が起きます。ある変更は単体なら良いが、別の変更と組み合わさると逆効果、というケースが発生し、原因追跡を難しくします。

4.2 解決策

1回のテストで扱う要素は1つずつにします。複数比較が必要な場合は、並列で別テストに分けるか、多変量テスト(MVT)を検討します。ただしMVTは必要サンプルが増えるため、トラフィックが十分にある場合に限定するのが現実的です。

実務では、まず「最も効果が出やすい変更」から単独で検証し、当たりを引いたら次の要素へ進めるのが効率的です。学びを積み上げる順序を設計すると、改善が加速します。

5. ターゲティングや対象ユーザーの誤り

誰に対して実験しているかがズレると、結果は簡単に歪みます。A/Bテストは「母集団が同じ」という前提で比較するため、セグメントの切り方は設計の一部です。

5.1 失敗の原因

テスト対象に関係ないユーザーを含めたり、セグメントが細かすぎるとサンプル数不足に陥り、結果が偏ったものになります。例えばリピーター向けの改善を全ユーザーに当てると、効果が薄まって見えることがあります。

また、デバイス、流入元、地域などの偏りがあると、ユーザー体験が異なるため、同じ変更でも影響が変わります。こうしたズレを無視すると、施策の評価を誤りやすくなります。

5.2 解決策

テスト対象を適切にセグメントし、比較可能なユーザー層でテストを実施します。必要に応じてセグメント別分析を行い、「どの層に効いたのか」を確認します。ただし、最初から細かく切りすぎると母数不足になるため、まずは大枠で検証し、効果が見えた段階で深掘りするのが現実的です。

加えて、セグメントを切るなら「事前に仮説として理由を持つ」ことが重要です。分析のための切り分けではなく、施策が効くはずのユーザー像を定義してから検証すると、結果の解釈がぶれにくくなります。

6. データ品質の問題

データが正しく取れていないテストは、どれだけ精密に設計しても結論が崩れます。A/Bテストでは「結果が少しの差」で語られることが多いため、計測のブレは致命的です。

6.1 失敗の原因

トラッキング設定ミスやツール導入の不備、外部要因(ページ読み込み速度など)がテスト結果に影響する場合があります。例えば一方のバリアントだけ表示が遅いと、内容ではなく速度で差が出ます。

また、イベント定義が曖昧だと、同じ行動でも計測方法が変わり、比較が成立しません。データ品質の問題は「施策の良し悪し」を誤認させるため、最も危険な失敗要因の一つです。

6.2 解決策

ツールで計測の整合性を検証し、データ収集の設定を整えます。あわせてA/Aテストを先に行い、計測環境が差を生まないことを確認するのも効果的です。A/Aで差が出るなら、テスト以前に計測・配信の問題が疑えます。

さらに、速度やエラー率などの技術指標を一緒に監視すると、外部要因を早期に発見できます。A/Bは「UXの勝敗」を見る前に、「計測と配信が公平か」を担保することが前提になります。

7. 結果の解釈不足

A/Bテストは、結果よりも「なぜそうなったか」を理解して初めて価値が出ます。合否判定だけで終わると、改善が再現できず、同じ失敗を繰り返しやすくなります。

7.1 失敗の原因

A/Bテスト結果を単なる「合格/不合格」で終えてしまうと、本質的な改善につながりません。勝った施策でも、どのユーザー行動が変化したのかを追わないと、次に何を最適化すべきか分からない状態になります。

また、負けた施策も「失敗」ではなく、条件や仮説が違っていた可能性があるだけです。解釈が浅いと、学びが残らず、改善の知識が組織に蓄積されません。

7.2 解決策

結果分析では、成功/失敗の理由を深掘りし、次のテストに活かす学びを抽出します。主要KPIだけでなく、ステップ到達率やクリック分布、離脱点などの補助指標を使って、行動変化の筋道を説明できる状態にします。

最後に、学びをチームで共有し、仮説・結果・示唆・次アクションをドキュメント化します。A/Bテストは「知識を貯める運用」にすると強くなり、短期の勝敗よりも長期の改善力が上がります。

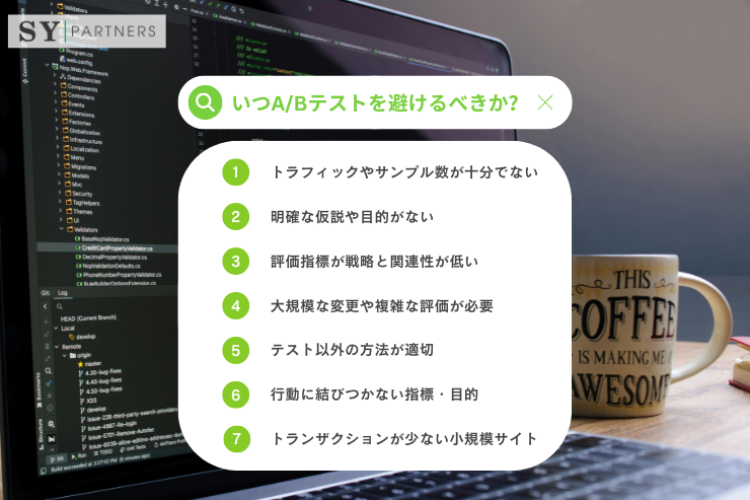

おわりに

A/Bテストが失敗する最大の理由は、「テスト結果そのもの」に期待しすぎてしまうことです。本来重要なのは勝敗ではなく、なぜその結果になったのかを説明できること、そしてその学びを次の施策に確実につなげられることです。仮説が曖昧なまま走るテスト、母数が足りない判断、ズレたKPI、同時に変えすぎた施策は、いずれも“学びが残らないテスト”を生みやすくします。

一方で、仮説を短く明確にし、必要なサンプルを確保し、目的に直結する指標を絞り、計測の公平性を担保した上で結果を丁寧に解釈すれば、A/Bテストは非常に強力な改善装置になります。負けたテストも含めて知見を蓄積し、チームで共有することで、改善の再現性は着実に高まります。

A/Bテストは単発の施策ではなく、組織の学習速度を上げるための運用です。短期の勝ち負けに一喜一憂するのではなく、「学びが積み上がっているか」という視点で見直すことで、テストは事業成長を支える確かな武器になります。

EN

EN JP

JP KR

KR